Oublier « natif numérique« Le terme qui fait référence à ceux qui ont commencé à interagir avec la technologie numérique à un jeune âge. » IA natif « est le nouveau label qui obtient des diplômés de niveau d’entrée de gamme à six ou sept chiffres dès la sortie de l’école – et il […]

Nous sommes ravis d’annoncer que Juan Cardona Ramirez a été reconnu comme un Champion partenaire de Databrick, Faire de lui le premier collègue perfictime en Amérique latine pour gagner cette prestigieuse désignation. Cette reconnaissance célèbre la technique profonde de Juan compétencecontributions cohérentes et engagement envers l’innovation dans l’écosystème de données. […]

Atteindre la lignée de bout en bout Databricks Bien que permettre aux utilisateurs externes d’accéder aux données brutes puisse être une tâche difficile. Dans Databricks, en tirant parti Catalogue d’unité pour lignée de bout en bout est une meilleure pratique. Cependant, l’activation des utilisateurs externes d’accéder aux données brutes tout […]

Le partenariat stratégique récent entre Databricks et Anthropique est un grand pas en avant pour permettre aux entreprises de construire, de déployer et de gouverner les agents de l’IA qui raisonnent sur les données propriétaires avec précision, sécurité et gouvernance. Le paysage de l’entreprise AI évolue rapidement, et nous sommes […]

Perficient est ravi d’annoncer que nous avons atteint Statut de partenaire de niveau d’élite Dans le réseau partenaire de Databricks. Cette reconnaissance de haut niveau met en évidence les efforts exceptionnels de nos talentueux stratèges de données, architectes, leaders de l’industrie et ingénieurs. Cela témoigne de nos données et de […]

Performance a un État d’esprit Finops avec Databricksdonc le Clustering liquide automatique L’annonce a attiré mon attention. J’ai mentionné le regroupement liquide avant Lorsque vous discutez des avantages du catalogue d’unité au-delà des cas d’utilisation de la gouvernance. Catalogue d’unité: venez pour le gouvernance des donnéesrestez pour le optimisation prédictive. […]

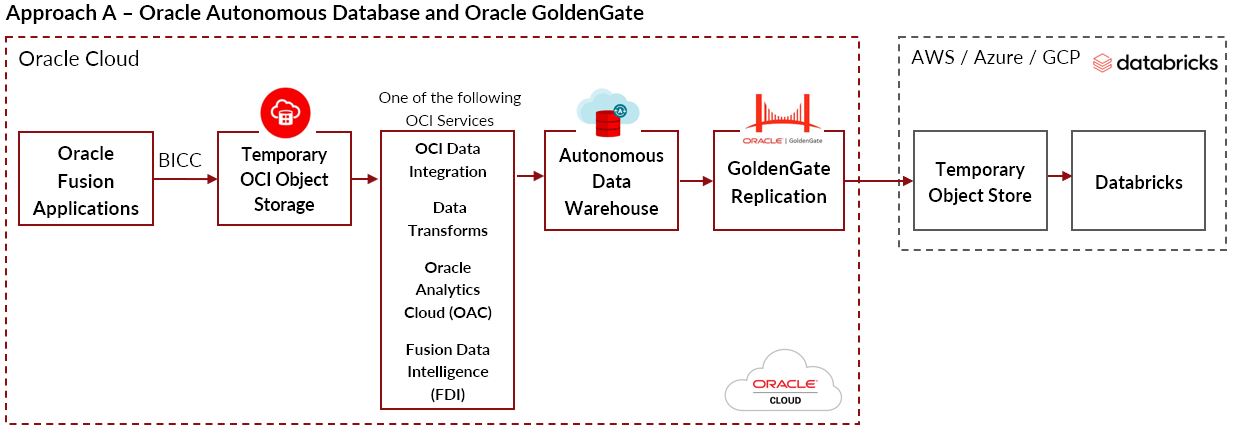

La connexion aux données des applications Cloud Oracle Fusion à partir de systèmes non oracle externes, comme Databricks, n’est pas possible pour les opérations de données en vrac via une connexion directe. Cependant, il existe plusieurs approches pour rendre les données Oracle Apps disponibles pour la consommation de Databricks. Ce […]

En tant que Champion de Databricks travailler pour Équipe de solutions de données de PerficientJe passe la majeure partie de mon temps à installer et à gérer les données sur Azuré et AWS. La décision sur le fournisseur de cloud à utiliser est généralement en dehors de ma portée car […]

Lors de Dreamforce 2024, Perficient a exploré l’intégration de Databricks et Salesforce Data Cloud, en se concentrant sur un cas d’utilisation du secteur de l’assurance. Cette session a présenté le traitement des données, l’engagement client et les informations basées sur l’IA, offrant une valeur réelle aux entreprises. Voici un récapitulatif […]

90 % des entreprises Fortune 500 utiliser Force de vente comme outil de gestion de la relation client. J’ai ingéré des données de Salesforce dans presque toutes les bases de données à l’aide de presque tous les outils ETL. Chaque intégration outil dehors là dispose d’un connecteur Salesforce ; Salesforce possède […]