GitHub Copilot est le premier vrai produit basé sur de grands modèles de langage

Cet article fait partie de notre série qui explore les métier de l’intelligence artificielle

Depuis GPT-2, il y a eu beaucoup d’enthousiasme autour des applications de grands modèles de langage. Et au cours des dernières années, nous avons vu des LLM utilisés pour de nombreuses tâches passionnantes, telles que la rédaction d’articles, la conception de sites Web, la création d’images et même l’écriture de code.

Mais comme je l’ai déjà dit, il y a un grand écart entre montrer qu’une nouvelle technologie fait quelque chose de cool et utiliser la même technologie pour créer un produit réussi avec un modèle commercial viable.

Microsoft, je pense, vient de lancer le premier vrai produit LLM avec le sortie publique de GitHub Copilot La semaine dernière. Il s’agit d’une application qui a une forte adéquation produit/marché, a une immense valeur ajoutée, est difficile à battre, est rentable, a des canaux de distribution très solides et peut devenir une source de gros profits.

La publication de GitHub Copilot rappelle deux choses : Premièrement, les LLM sont fascinants, mais ils sont utiles lorsqu’ils sont appliqués à des tâches spécifiques par opposition à intelligence artificielle générale. Et deuxièmement, la nature des LLM place les grandes entreprises technologiques comme Microsoft et Google à un avantage injuste pour les commercialiser – les LLM ne sont pas démocratiques.

LLM spécialisé

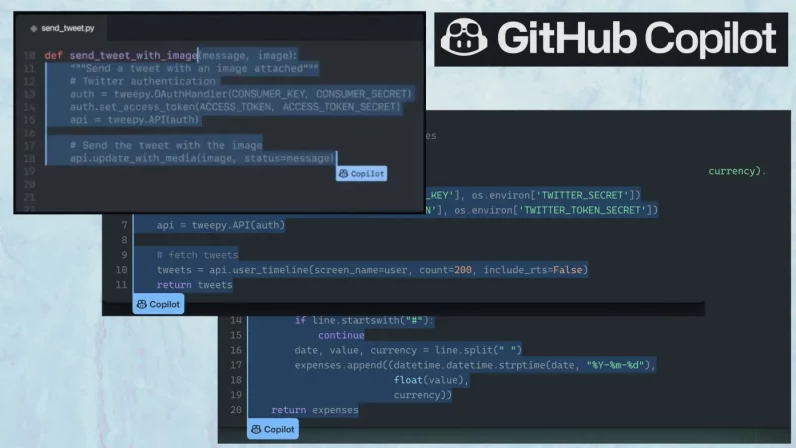

Le copilote est un Outil de programmation IA qui est installé en tant qu’extension sur les IDE populaires tels que Visual Studio et VS Code. Il fournit des suggestions au fur et à mesure que vous écrivez du code, quelque chose comme la saisie semi-automatique mais pour la programmation. Ses capacités vont de l’achèvement d’une ligne de code à la création de blocs entiers de code tels que des fonctions et des classes.

Copilot est propulsé par Manuscritune version de Le célèbre modèle GPT-3 d’OpenAI, un grand modèle de langage qui a fait la une des journaux pour sa capacité à effectuer un large éventail de tâches. Cependant, contrairement à GPT-3, le Codex a été affiné uniquement pour les tâches de programmation. Et cela produit des résultats impressionnants.

Le succès de GitHub Copilot et Codex souligne un fait important. Lorsqu’il s’agit d’utiliser réellement les LLM, la spécialisation l’emporte sur la généralisation. Lorsque Copilot a été introduit pour la première fois en 2021, CNBC a rapporté: « … à l’époque où OpenAI s’entraînait pour la première fois [GPT-3]la start-up n’avait pas l’intention de lui apprendre à aider à coder, [OpenAI CTO Greg] dit Brockman. Il s’agissait davantage d’un modèle de langage à usage général [emphasis mine] qui pourrait, par exemple, générer des articles, corriger une grammaire incorrecte et traduire d’une langue dans une autre.

Mais alors que GPT-3 a rencontré un léger succès dans diverses applications, Copilot et Codex se sont avérés être de grands succès dans un domaine spécifique. Le codex ne sait pas écrire poésie ou articles comme GPT-3, mais il s’est avéré très utile pour les développeurs de différents niveaux d’expertise. Codex est également beaucoup plus petit que GPT-3, ce qui signifie qu’il est plus efficace en termes de mémoire et de calcul. Et étant donné qu’il a été formé pour une tâche spécifique par opposition au monde ouvert et ambigu du langage humain, il est moins enclin à pièges dans lesquels tombent souvent des modèles comme le GPT-3.

Il convient toutefois de noter que, tout comme GPT-3 ne sait rien du langage humain, Copilot ne connaît rien au code informatique. C’est un modèle de transformateur qui a été formé sur des millions de référentiels de code. Étant donné une invite (par exemple, un morceau de code ou une description textuelle), il essaiera de prédire la prochaine séquence d’instructions qui a le plus de sens.

Avec son énorme corpus d’entraînement et son réseau de neurones massif, Copilot fait surtout de bonnes prédictions. Mais parfois, il peut faire des erreurs stupides que le programmeur le plus novice éviterait. Il ne pense pas aux programmes comme le fait un programmeur. Il ne peut pas concevoir de logiciel ou penser par étapes et penser aux exigences et à l’expérience des utilisateurs et à toutes les autres choses qui entrent dans la création d’applications réussies. C’est ne remplace pas les programmeurs humains.

Adéquation produit/marché de Copilot

L’une des étapes importantes pour tout produit est d’atteindre l’adéquation produit/marché ou de prouver qu’il peut résoudre certains problèmes mieux que les solutions alternatives du marché. À cet égard, Copilot a été un succès retentissant.

GitHub a lancé Copilot en avant-première en juin dernier et a depuis été utilisé par plus d’un million de développeurs.

Selon GitHub, dans les fichiers où Copilot est activé, il représente environ 40 % du code écrit. Développeurs et ingénieurs j’ai parlé la semaine dernière dire que bien qu’il y ait des limites aux capacités de Copilot, il est indéniable qu’il améliore considérablement leur productivité.

Pour certains cas d’utilisation, Copilot est en concurrence avec StackOverflow et d’autres forums de code, où les utilisateurs doivent rechercher la solution à un problème spécifique auquel ils sont confrontés. Dans ce cas, la valeur ajoutée de Copilot est très évidente et palpable : moins de frustration et de distraction, plus de concentration. Au lieu de quitter leur IDE et de rechercher une solution sur le Web, les développeurs tapent simplement la description ou la docstring de la fonctionnalité qu’ils souhaitent, et Copilot fait la majeure partie du travail à leur place.

Dans d’autres cas, Copilot est en concurrence avec l’écriture manuelle de code frustrant, comme la configuration de graphiques matplotlib en Python (une tâche super frustrante). Bien que la sortie de Copilot puisse nécessiter quelques ajustements, elle soulage la majeure partie du fardeau des développeurs.

Dans de nombreux autres cas d’utilisation, Copilot a pu s’imposer comme une solution supérieure aux problèmes auxquels de nombreux développeurs sont confrontés chaque jour. Les développeurs m’ont parlé de choses telles que l’exécution de cas de test, la configuration de serveurs Web, la documentation de code et de nombreuses autres tâches qui nécessitaient auparavant un effort manuel et étaient ardues. Copilot les a aidés à gagner beaucoup de temps dans leur travail quotidien.

Distribution et rentabilité

L’adéquation produit/marché n’est qu’une des nombreuses composantes de la création d’un produit performant. Si vous avez un bon produit mais que vous ne trouvez pas les bons canaux de distribution pour fournir sa valeur d’une manière rentable et rentable, alors vous êtes voué à l’échec. Dans le même temps, vous aurez besoin d’un plan pour conserver votre avantage sur vos concurrents, empêcher d’autres entreprises de reproduire votre succès et vous assurer que vous pouvez continuer à générer de la valeur sur la durée.

Pour faire de Copilot un produit performant, Microsoft devait réunir plusieurs éléments très importants, notamment la technologie, l’infrastructure et le marché.

Premièrement, elle avait besoin de la bonne technologie, qu’elle a acquise grâce à son licence exclusive sur la technologie d’OpenAI. Depuis 2019, OpenAI a cessé d’ouvrir sa technologie et la licencie à la place à ses bailleurs de fonds, au premier rang desquels Microsoft. Codex et Copilot ont été créés à partir de GPT-3 avec l’aide des scientifiques d’OpenAI.

D’autres grandes entreprises technologiques ont pu créer de grands modèles de langage comparables à GPT-3. Mais il est indéniable que les LLM sont très coûteux à former et à courir.

« Pour un modèle 10 fois plus petit que Codex – le modèle derrière Copilot (qui a des paramètres 12B sur le papier) – il faut des centaines de dollars pour faire l’évaluation sur ce référence qu’ils ont utilisé dans leur article », a déclaré Loubna Ben Allal, ingénieure en apprentissage automatique chez Hugging Face, à TechTalks. Ben Allal a évoqué une autre référence utilisé pour l’évaluation du Codex, qui a coûté des milliers de dollars pour son propre modèle plus petit.

« Il existe également des problèmes de sécurité car vous devez exécuter des programmes non fiables pour évaluer le modèle qui pourrait être malveillant, les bacs à sable sont généralement utilisés pour la sécurité », a déclaré Ben Allal.

Leandro von Werra, un autre ingénieur ML chez Hugging Face, a estimé que les coûts de formation se situent entre des dizaines et des centaines de milliers de dollars selon la taille et le nombre d’expériences nécessaires pour bien faire les choses.

« L’inférence est l’un des plus grands défis », a ajouté von Werra dans les commentaires de TechTalks. « Alors que presque n’importe qui avec des ressources peut former un modèle 10B de nos jours, obtenir une latence d’inférence suffisamment faible pour se sentir réactif à l’utilisateur est un défi d’ingénierie. »

C’est là que le deuxième avantage de Microsoft entre en jeu. L’entreprise a été en mesure de créer une grande infrastructure cloud spécialisée pour les modèles d’apprentissage automatique tels que Codex. Il exécute l’inférence et fournit des suggestions en quelques millisecondes. Et plus important encore, Microsoft est en mesure d’exécuter et de fournir Copilot à un prix très abordable. Actuellement, Copilot est proposé à 10 $/mois ou 100 $/an, et il sera fourni gratuitement aux étudiants et aux mainteneurs de référentiels open source populaires.

La plupart des développeurs à qui j’ai parlé étaient très satisfaits du modèle de tarification car il leur faisait gagner beaucoup plus de temps que son prix.

Abhishek Thakur, un autre ingénieur ML chez Hugging Face à qui j’ai parlé plus tôt cette semaine, a déclaré: «En tant qu’ingénieur en apprentissage automatique, je sais que beaucoup entre dans la construction de produits comme ceux-ci, en particulier Copilot, qui fournit des suggestions avec une latence inférieure à la milliseconde. Construire une infrastructure qui sert gratuitement ce type de modèles n’est pas réalisable dans le monde réel pendant une période plus longue.

Cependant, il n’est pas impossible d’exécuter des LLM de générateur de code à des tarifs abordables.

« En termes de calcul pour construire ces modèles et les données nécessaires : c’est tout à fait faisable et il y a eu quelques réplications de Codex telles que Incoder de Meta et CodeGen (désormais accessible gratuitement sur le Hugging Face Hub) de Salesforce égalant les performances de Codex », a déclaré von Werra. « Il y a certainement une certaine ingénierie impliquée dans la construction des modèles en un produit rapide et agréable, mais il semble que de nombreuses entreprises pourraient le faire si elles le souhaitent. »

Cependant, c’est là que la troisième pièce du puzzle entre en jeu. L’acquisition de GitHub par Microsoft lui a donné accès au plus grand marché de développeurs, ce qui a permis à l’entreprise de mettre facilement Copilot entre les mains de millions d’utilisateurs. Microsoft possède également Visual Studio et VS Code, deux des IDE les plus populaires avec des centaines de millions d’utilisateurs. Cela réduit la friction pour les développeurs d’adopter Copilot par opposition à un autre produit similaire.

Avec ses prix, son efficacité et sa portée sur le marché, Microsoft semble avoir consolidé sa position de leader sur le marché émergent du développement de logiciels assisté par l’IA. Le marché peut prendre d’autres tournants. Ce qui est sûr (et comme je l’ai déjà souligné) est que les grands modèles de langage ouvriront de nombreuses opportunités pour créer de nouvelles applications et de nouveaux marchés. Mais ils ne changeront pas les principes fondamentaux d’une saine gestion des produits.

Cet article a été initialement publié par Ben Dickson sur TechTalks, une publication qui examine les tendances de la technologie, comment elles affectent notre façon de vivre et de faire des affaires, et les problèmes qu’elles résolvent. Mais nous discutons également du côté pervers de la technologie, des implications les plus sombres des nouvelles technologies et de ce que nous devons surveiller. Vous pouvez lire l’article original ici.

Source link