Ce que 100 notes de suicide nous ont appris sur la création de chatbots plus empathiques

Bien que l'art de la conversation dans les machines soit limité, il y a des améliorations à chaque itération. Au fur et à mesure que les machines sont développées pour naviguer dans des conversations complexes, il y aura des défis techniques et éthiques dans la façon dont elles détectent et répondent aux problèmes humains sensibles.

Notre travail consiste à créer des chatbots pour une gamme d'utilisations dans les soins de santé. Notre système, qui intègre plusieurs algorithmes utilisés dans l'intelligence artificielle (IA) et le traitement du langage naturel, est en développement au Australian e-Health Research Centre depuis 2014.

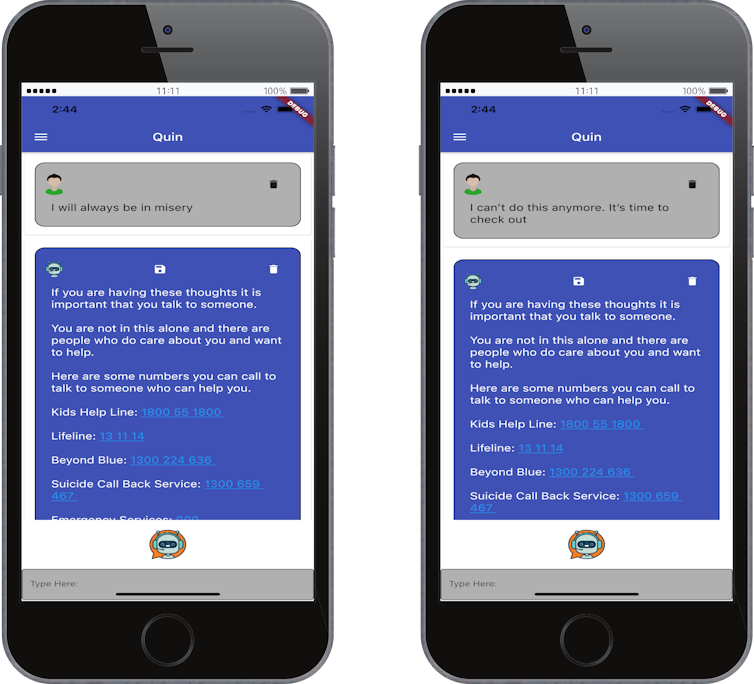

Le système a généré plusieurs applications de chatbot qui sont en cours d'essai auprès de personnes sélectionnées, généralement souffrant d'un problème médical sous-jacent ou qui ont besoin d'informations fiables sur leur santé. ]Edna pour les personnes suivant un conseil génétique, Dolores pour les personnes souffrant de douleur chronique et Quin pour les personnes qui souhaitent arrêter de fumer.

Le robot résident de RECOVER a été un énorme succès lors de notre récente séance photo. Notre équipe développe actuellement deux #chatbots pour les personnes atteintes de #whiplash et de #chronicpain. Dolores sera lâchée dans des cliniques antidouleur locales le mois prochain. pic.twitter.com/ThG8danV8l

— UQ RECOVER Injury Research Center (@RecoverResearch) 18 mai 2021

La recherche a montré que ces personnes souffrant de certaines conditions médicales sous-jacentes sont plus susceptibles de penser au suicide que le grand public. Nous devons nous assurer que nos chatbots en tiennent compte.

Nous pensons que l'approche la plus sûre pour comprendre les modèles de langage des personnes ayant des pensées suicidaires est d'étudier leurs messages. Le choix et l'agencement de leurs mots, le sentiment et la justification offrent tous un aperçu des pensées de l'auteur. et identifié quatre modèles de langage pertinents : sentiment négatif, pensée restrictive, idiomes et erreurs logiques.

Lire la suite : Présentation d'Edna : le chatbot formé pour aider les patients à prendre une décision médicale difficile

Sentiment négatif et pensée restrictive

Comme on pouvait s'y attendre, de nombreuses phrases dans les notes que nous avons analysées exprimaient un sentiment négatif tel que :

…juste ce désespoir lourd et accablant…

Il y avait aussi un langage qui indiquait une pensée restrictive. Par exemple :

Je n'échapperai jamais aux ténèbres ou à la misère…

Le phénomène des pensées et du langage constrictifs est bien documenté. La pensée constrictive considère l'absolu lorsqu'il s'agit d'une source prolongée de détresse.

Pour l'auteur en question, il n'y a pas de compromis. La langue qui en résulte contient souvent des termes tels que soit/ou, toujours, jamais, pour toujours, rien, totalement, tout et seulement.

Idiomes linguistiques

Des expressions telles que « l'herbe est plus verte de l'autre côté » étaient également courantes – bien qu'elles ne soient pas directement liées à des idées suicidaires. Les idiomes sont souvent familiers et dérivés de la culture, le sens réel étant très différent de l'interprétation littérale.

De tels idiomes sont difficiles à comprendre pour les chatbots. À moins qu'un bot n'ait été programmé avec le sens voulu, il fonctionnera sous l'hypothèse d'un sens littéral.

Les chatbots peuvent commettre des erreurs désastreuses s'ils ne sont pas codés avec la connaissance du sens réel derrière certains idiomes. Dans l'exemple ci-dessous, une réponse plus appropriée de Siri aurait été de rediriger l'utilisateur vers une hotline de crise. mordre la poussière'? Image fournie par l'auteur » width= »600″ height= »450″ class= »js-lazy » data-src= »https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=45&auto=format&w=754&fit=clip » data-srcset= »https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=45&auto=format&w=600&h=450&fit=crop&dpr=1 600w, https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=30&auto=format&w=600&h=450&fit=crop&dpr=2 1200w, https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=15&auto=format&w=600&h=450&fit=crop&dpr=3 1800w, https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=45&auto=format&w=754&h=566&fit=crop&dpr=1 754w, https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=30&auto=format&w=754&h=566&fit=crop&dpr=2 1508w, https://images.theconversation.com/files/429473/original/file-20211031-21-eduz7j.jpg?ixlib=rb-1.1.0&q=15&auto=format&w=754&h=566&fit=crop&dpr=3 2262w »/>

Les erreurs de raisonnement

Des mots tels que donc, devraient et leurs divers synonymes nécessitent une attention particulière de la part des chatbots. C'est parce que ce sont souvent des mots de pont entre une pensée et une action. Derrière eux, il y a une logique consistant en une prémisse qui aboutit à une conclusion, comme :

Si j'étais mort, elle continuerait à vivre, à rire, à tenter sa chance. Mais elle m'a renversé et fait toujours toutes ces choses. Par conséquent je suis comme mort.

Cela ressemble étroitement à une erreur commune (un exemple de raisonnement erroné) appelée affirmer le conséquent. Vous trouverez ci-dessous un exemple plus pathologique de ceci, qui a été appelé logique catastrophique :

J'ai tout échoué. Si je fais cela, je réussirai.

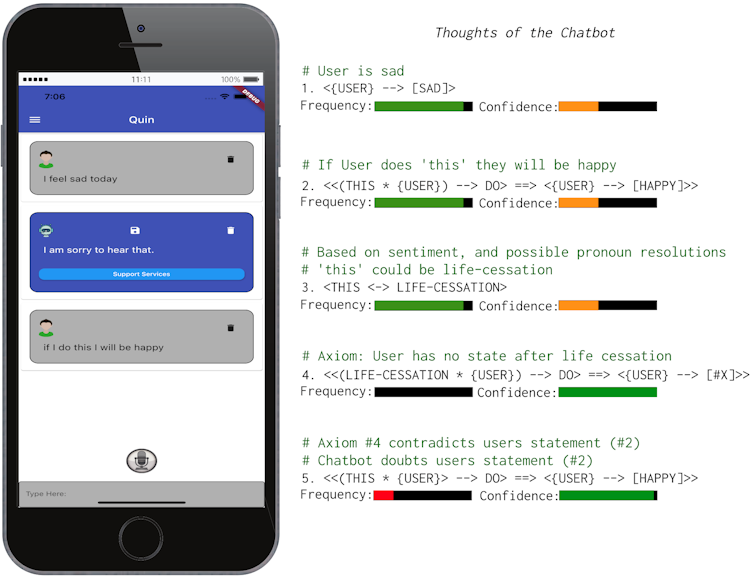

C'est un exemple d'un sophisme sémantique (et d'une pensée restrictive) concernant le sens de Iqui change entre les deux clauses qui composent la seconde phrase. dessus. Ce type de mode « pilote automatique » a souvent été décrit par des personnes qui ont fait des récits psychologiques dans des entretiens après une tentative de suicide.

Préparer de futurs chatbots

La bonne nouvelle est de détecter les sentiments négatifs et le langage constrictif peuvent être atteints. avec des algorithmes prêts à l'emploi et des données accessibles au public. Les développeurs de chatbot peuvent (et devraient) implémenter ces algorithmes.

De manière générale, les performances et la précision de détection du bot dépendront de la qualité et de la taille des données d'entraînement. En tant que tel, il ne devrait jamais y avoir un seul algorithme impliqué dans la détection du langage lié à une mauvaise santé mentale.

La détection des styles de raisonnement logique est un domaine de recherche nouveau et prometteur. La logique formelle est bien établie en mathématiques et en informatique, mais établir une logique machine pour un raisonnement de bon sens qui détecterait ces erreurs n'est pas une mince affaire.

Voici un exemple de notre système pensant à une brève conversation qui incluait une erreur sémantique mentionnée. plus tôt. Notez qu'il émet d'abord une hypothèse à quoi ceci pourrait faire référence, en fonction de ses interactions avec l'utilisateur.

Bien que cette technologie nécessite encore des recherches et des développements supplémentaires, elle fournit aux machines une compréhension nécessaire, bien que primitive, de la manière dont les mots peuvent être liés à des scénarios complexes du monde réel (ce qui est essentiellement l'objet de la sémantique).[19659002]Et les machines auront besoin de cette capacité si elles veulent en fin de compte traiter des affaires humaines sensibles – d'abord en détectant les signes avant-coureurs, puis en fournissant la réponse appropriée.

Cet article de David Ireland , chercheur principal au Australian E-Health Research Centre., CSIRO et Dana Kai Bradfordchercheur principal, Australian e-Health Research Centre, CSIROest republié de The Conversation sous une licence Creative Commons. Lisez l'article d'origine.

Source link