Boost cognitif basé sur l’AI pour la chasse au cyber-menace

Chaque jour, les chasseurs de menaces naviguent dans une mer écrasante de données, passant à travers d’innombrables journaux provenant de diverses sources. Ces journaux, même après avoir été traduits en alertes par divers outils analytiques, exigent une attention constante et un examen minutieux. Les analystes de la sécurité doivent étudier manuellement des milliers d’alertes tout en faisant référence fréquemment des sources de renseignement des menaces externes telles que BrightCloud. Malgré la disponibilité de plates-formes d’analyse sophistiquées, le volume et la complexité des données font de la détection efficace des menaces une tâche intimidante.

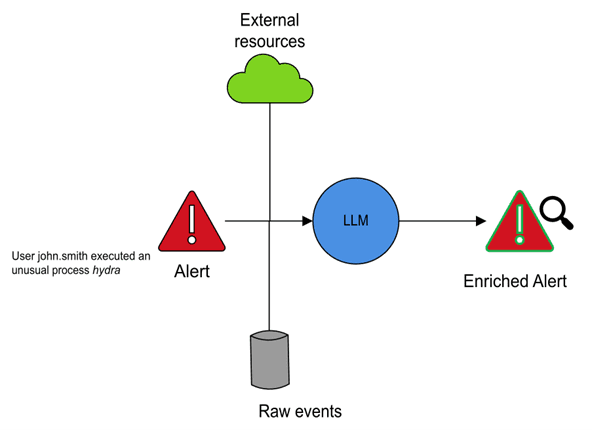

En intégrant l’IA dans le processus de chasse aux menaces, les alertes peuvent être enrichies avec des informations contextuelles plus profondes réduisant ainsi la charge de travail manuelle. Le résumé axé sur l’IA peut distiller de grandes quantités d’informations dans des résumés et des récits concis et exploitables, aidant les analystes à se concentrer plus rapidement sur les menaces critiques. De plus, l’IA peut automatiser la génération de rapports et même suggérer des stratégies de réponse, rationalisant la résolution des incidents.

Réduire la fatigue alerte avec un enrichissement alimenté par AI

Presque tous les outils de sécurité du marché aujourd’hui peuvent générer des alertes après avoir analysé les journaux. Ces alertes peuvent être basées sur des règles ou dérivées des modèles d’apprentissage automatique et aider à réduire la charge de millions d’événements logarithmiques à un nombre plus gérable d’alertes. Cependant, même à cette échelle réduite, l’étude de ces alertes volumineuses reste un défi qui prend beaucoup de temps pour les chasseurs de menaces.

Chaque alerte nécessite une plongée profonde dans les événements bruts sous-jacents pour extraire les détails contextuels. Les analystes doivent également référer manuellement les sources multiples, recherchant des informations telles que les hachages de processus ou les adresses IP distantes dans les bases de données de renseignement des menaces pour déterminer si elles apparaissent dans les listes noires connues. Après tous ces efforts, la plupart des alertes se révèlent souvent être de faux positifs, conduisant au temps perdu et à la fatigue des analystes.

L’IA générative peut jouer un rôle puissant En enrichissant automatiquement les alertes de sécurité avec des renseignements contextuels, ce qui a considérablement assoupli le fardeau des chasseurs de menaces. Par exemple, lorsque l’exécution d’un processus inhabituel déclenche une alerte, les analystes ont généralement besoin d’enquêter manuellement. Ils recherchent le hachage du processus pour déterminer s’il est lié à des logiciels malveillants connus, examiner les processus parents et grands-parents pour les anomalies et analyser les arguments de ligne de commande utilisés pendant l’exécution.

Les organisations peuvent automatiser une grande partie de ce travail d’investigation avec les progrès récents de l’IA générative. L’IA peut générer des descriptions d’alerte améliorées incorporant des détails critiques. Il s’agit notamment de la lignée de processus, des entrées de ligne de commande et des recherches en temps réel pour les hachages et les adresses IP. Cette information enrichie permet aux analystes de porter des jugements plus rapides et plus précis sur les alertes justifiés une enquête plus approfondie. Cela leur permet également d’identifier les faux positifs. En minimisant l’effort manuel et en améliorant la qualité des décisions, l’enrichissement basé sur l’IA aide les équipes de sécurité à réduire le bruit et à se concentrer sur de véritables menaces.

Amélioration de l’analyse des menaces basée sur les entités avec un résumé de l’IA

Les outils d’analyse des comportements des utilisateurs et des entités (UEBA), tels que la détection et la réponse de la menace de base, repartent davantage la détection des menaces en agrégeant les alertes basées sur des entités associées telles que les utilisateurs, les machines, les adresses IP, etc. Au lieu d’analyser les alertes individuelles isolément, ces outils calculent un score de risque pour chaque entité en fonction de leurs alertes associées, permettant aux chasseurs de menaces d’évaluer les incidents de sécurité de manière holistique. Cette approche aide à identifier les modèles qui pourraient autrement passer inaperçus, y compris les connexions entre des alertes apparemment à faible sévérité qui, lorsqu’elles sont corrélées, révèlent une menace de sécurité plus importante.

Dans cette approche, les chasseurs de menaces priorisent généralement leurs enquêtes sur les entités en fonction des scores des risques et examinent manuellement leurs alertes correspondantes pour reconstruire le calendrier de l’activité d’une entité. Cependant, ce processus nécessite encore beaucoup de temps et d’efforts pour assembler plusieurs alertes et construire une histoire cohérente.

Rationalisation avec l’IA générative

L’IA générative peut rationaliser ce processus en résumant automatiquement les activités anormales pour chaque entité à haut risque, offrant un aperçu concis mais complet parallèlement au score de risque. Le workflow implique généralement les étapes suivantes:

- Identification des entités à haut risque et des fenêtres temporelles pertinentes: L’accent est mis sur les entités qui accumulent des scores de risque plus élevés en fonction de leurs alertes associées au cours d’une période donnée.

- Anomalies de classement: Les anomalies sont prioritaires en fonction de leur contribution au risque de l’entité. Ce classement considère des facteurs tels que l’importance des entités associées, le poids du modèle d’anomalie, la nature de l’activité suspecte, etc.

- Sélection et comprimer les principales anomalies: Pour assurer une vue holistique, un ensemble organisé d’anomalies significatives est choisi à travers diverses dimensions comportementales, telles que les modèles d’accès, les modèles d’authentification ou les anomalies d’accès.

- Construire le récit anormal: Un modèle grand langage (LLM) génère un résumé lisible par l’homme qui couvre ces anomalies dans une histoire cohérente. Ce récit contextualise les alertes dispersées dans un scénario de menace significatif, aidant les analystes à comprendre ce qui s’est passé immédiatement.

En mettant en évidence les comportements clés et en les liant à l’image des risques plus large, ces résumés générés par l’IA permettent aux analystes de concentrer leur temps et leur expertise sur les entités qui comptent le plus. Cette approche accélère la prise de décision et minimise le risque de manquer les menaces de sécurité critiques cachées dans le bruit d’alerte. Ce récit est encore renforcé en associant des techniques potentielles d’attr & ck mitres qui mappent aux activités observées de l’entité – un sujet que nous explorerons plus en détail dans un prochain article de blog.

Des idées entités aux résumés organisationnels

Bien que les résumés au niveau de l’entité aident efficacement les chasseurs à la menace des chasseurs, des machines ou des IPS, ils peuvent étendre la même approche axée sur l’IA pour fournir une vision plus large de la posture de sécurité globale d’une organisation. En agrégeant les scores des risques, les activités anormales et les tendances sur plusieurs entités, l’IA peut générer un résumé de haut niveau de l’État de sécurité d’une organisation à tout moment.

Cette visibilité au niveau organisationnel permet aux équipes de sécurité d’identifier les schémas d’attaque plus importants, les menaces persistantes et les domaines de préoccupation qui pourraient ne pas être évidents à partir d’alertes individuelles. Plus important encore, l’IA peut automatiser la génération de résumés des dirigeants et des rapports de sécurité détaillés, offrant aux CISO et autres parties prenantes clairement un aperçu du paysage des menaces de l’entreprise.

Réponses plus intelligentes axées

Les équipes de sécurité s’appuient souvent sur des expériences passées et des stratégies de réponse documentées pour gérer efficacement les menaces récurrentes. Cependant, la recherche manuelle dans les cas antérieurs, les rapports d’incident et les livres de jeu de réponse peut prendre du temps et inefficace. Les modèles de grande langue affinés (LLM) intégrés à la génération (RAG) de la récupération (RAG) peuvent prendre une réponse aux incidents au niveau suivant en apprenant des incidents de sécurité historiques d’une organisation.

Cette approche accélère la résolution des incidents et améliore la précision de la réponse en réduisant la dépendance à la recherche manuelle. Les équipes de sécurité peuvent se concentrer sur l’exécution de la meilleure ligne de conduite plutôt que de passer un temps précieux à rassembler les données historiques. En fin de compte, les recommandations de réponse alimentées par l’IA transforment la chasse aux menaces d’un processus réactif en une stratégie de cybersécurité proactive et adaptative.

Relever les défis clés dans les solutions de chasse aux menaces axées

Bien que l’IA améliore considérablement les flux de travail de chasse aux menaces, son adoption est accompagnée de plusieurs défis que les organisations doivent relever pour assurer la sécurité, l’exactitude et la convivialité.

Sécurité des données

Les journaux de sécurité pourraient contenir des informations très sensibles cruciales pour la stratégie de défense d’une organisation. Permettre à ces journaux de laisser un environnement sécurisé pour le traitement de l’IA présente un risque que de nombreuses organisations ne disposent pas de prendre. Pour atténuer cela, les modèles d’IA doivent être hébergés dans le cloud privé virtuel (VPC) d’une organisation, garantissant que toutes les données restent dans un environnement contrôlé et protégé. Cette approche permet aux organisations de tirer parti des avantages de l’IA tout en maintenant le respect des politiques de sécurité des données.

Représentation des données

Les données de sécurité existent dans divers schémas, contenant souvent des terminologies et des abréviations uniques spécifiques à une organisation. Cette incohérence rend difficile pour les modèles d’IA d’interpréter et de traiter efficacement les données. Le mécanisme de récupération doit être conçu pour extraire des informations significatives tout en normalisant les terminologies internes dans un format compréhensible par le modèle d’IA. La normalisation garantit des informations précises et empêche l’interprétation erronée en raison des incohérences de la structure des données.

Invitation et cohérence de sortie

S’assurer que les sorties générées par l’AI adhèrent à une structure cohérente est essentielle pour la convivialité. Par exemple, si un moteur d’interface utilisateur s’attend à des réponses dans un format JSON spécifique avec des clés prédéfinies, les écarts de cette norme pourraient briser l’interface. De même, les rapports et les résumés doivent suivre une structure et un langage uniformes pour maintenir la clarté et la convivialité. L’établissement de solides pratiques d’ingénierie rapide garantit que les sorties d’IA restent prévisibles et s’intègrent parfaitement aux flux de travail de sécurité existants.

Relever ces défis est essentiel pour intégrer avec succès l’IA dans les opérations de chasse aux menaces.

Conclusion: L’avenir de la chasse aux menaces AI-Augmentation

La fusion de l’expertise humaine avec une efficacité alimentée par l’IA n’est pas seulement un avantage – elle devient nécessaire dans le paysage des menaces en constante évolution. À mesure que les cybermenaces deviennent plus sophistiquées, la demande d’analyse en temps réel, de prise de décision rapide et de réponse précise des incidents est plus élevée que jamais. Bien que l’IA ait déjà démontré sa valeur dans l’enrichissement des alertes et le résumé des événements de sécurité, son rôle dans la défense des menaces proactifs en utilisant des mécanismes tels que l’agent IA est toujours en pleine expansion. En analysant de manière autonome les modèles, en détectant les menaces émergentes et en prenant des actions défensives prédéfinies, l’agence d’IA transforme la cybersécurité d’un modèle réactif en une stratégie de défense proactive et adaptative.

Rejoignez les scientifiques des données de cybersécurité OpenText @ RSA 2025 Là où mes collègues et collègues scientifiques des données, Nakkul Khuraana, et Hari Manassery Koduvly, discuteront de «comment utiliser les LLM pour augmenter les alertes de menace avec le cadre de Mitre».

Source link