Guide du débutant sur l’apocalypse de l’IA : la démocratisation de « l’expertise »

Dans cette série, nous examinons certains des scénarios apocalyptiques les plus populaires pronostiqués par les IA experts. Articles précédents jeinclure Objectifs mal alignés, Stupidité Artificielle, Syndrome de Wall-E, L’humanité rejoint l’esprit de la rucheet Robots tueurs.

Nous avons couvert beaucoup de terrain dans cette série (voir ci-dessus), mais rien ne se rapproche de notre prochain sujet. La « démocratisation de l’expertise » peut sembler une bonne chose — la démocratie, l’expertise, qu’est-ce qu’il ne faut pas aimer ? Mais notre intention est de vous convaincre qu’il s’agit de la plus grande menace liée à l’IA à laquelle notre espèce est confrontée au moment où vous aurez fini de lire cet article.

Pour bien comprendre cela, il va falloir revenir sur un post précédent à propos de ce que l’on aime appeler « Syndrome de WALL-E.” C’est une condition inventée où nous devenons si dépendants de l’automatisation et de la technologie que nos corps deviennent mous et faibles jusqu’à ce que nous ne soyons plus capables de fonctionner sans l’aide physique des machines.

Lorsque nous définissons ce qu’est la «démocratisation de l’expertise», nous parlons spécifiquement de quelque chose qui pourrait être décrit plus facilement comme le «syndrome de WALL-E pour le cerveau».

Je veux être prudent en notant que nous ne faisons pas référence à la démocratisation de l’information, quelque chose qui est crucial pour la liberté humaine.

La grande idée

Il existe un jeu de société populaire appelé « Trivial Pursuit” qui met les joueurs au défi de répondre à des questions triviales sans rapport avec une variété de catégories. Il existe depuis bien avant l’aube d’Internet et est donc conçu pour être joué en utilisant uniquement les connaissances que vous avez déjà dans votre cerveau.

Vous lancez des dés et déplacez une pièce de jeu autour d’un plateau jusqu’à ce qu’elle s’immobilise, généralement sur un carré de couleur. Vous tirez ensuite une carte d’un grand jeu de questions et tentez de répondre à celle qui correspond à la couleur sur laquelle vous avez atterri. Pour déterminer si vous avez réussi, retournez la carte et voyez si votre réponse correspond à celle imprimée.

Une partie de Trivial Pursuit n’est aussi « précise » que sa base de données. Cela signifie que si vous jouez à l’édition 1999 et que vous recevez une question vous demandant quel joueur de la MLB détient le record du plus grand nombre de circuits en une saison, vous devrez répondre de manière incorrecte à la question afin de correspondre à la réponse imprimée.

La bonne réponse est « Barry Bonds with 73 ». Mais, comme Bonds n’a battu le record qu’en 2001, l’édition de 1999 répertorie très probablement le record de 1998 de 70 du détenteur du record précédent Mark McGwire.

Le problème avec les bases de données, même lorsqu’elles sont organisées et étiquetées à la main par des experts, c’est qu’elles ne représentent qu’une tranche de données à un moment donné.

Maintenant, étendons cette idée dans une base de données qui n’est pas organisée par des experts. Imaginez un jeu de Trivial Pursuit qui fonctionne exactement de la même manière que l’édition vanille, sauf que les réponses à chaque question ont été obtenues par des personnes aléatoires.

« Quel est l’élément le plus léger du tableau périodique ? » Réponse, agrégée, selon 100 personnes au hasard que nous avons interrogées à Times Square : « Je ne sais pas, peut-être de l’hélium ? »

Cependant, dans la prochaine édition, la réponse pourrait changer en quelque chose comme « Selon 100 lycéens choisis au hasard, la réponse est l’hydrogène.

Qu’est-ce que cela a à voir avec l’IA ?

Parfois, la sagesse des foules est utile. Par exemple, lorsque vous essayez de savoir quoi regarder ensuite. Mais parfois, c’est vraiment stupide, comme si l’année était 1953 et que vous demandiez à une foule de 1 000 scientifiques si les femmes peuvent avoir des orgasmes.

Son utilité pour les grands modèles de langage (LLM) dépend de la manière dont ils sont utilisés.

Les LLM sont un type de système d’IA utilisé dans une grande variété d’applications. Google Translate, le chat bot du site Web de votre banque, et le tristement célèbre OpenAI GPT-3 sont tous des exemples de technologie LLM en cours d’utilisation.

Dans le cas de Translate et des chatbots orientés entreprise, l’IA est généralement formée sur des ensembles de données d’informations soigneusement conservés, car ils servent un objectif étroit.

Mais de nombreux LLM sont intentionnellement formés sur des bennes géantes remplies de données non vérifiées, juste pour que les personnes qui les construisent puissent voir de quoi ils sont capables.

La grande technologie nous a convaincus qu’il est possible de faire pousser ces machines si grandes qu’elles finissent par devenir conscientes. La promesse est qu’ils seront capables de faire tout ce qu’un humain peut faire, mais avec le cerveau d’un ordinateur !

Et vous n’avez pas besoin de chercher très loin pour imaginer les possibilités. Prenez 10 minutes et discutez avec BlenderBot 3 de Meta (BB3) et vous verrez de quoi il s’agit.

C’est un gâchis fragile et facilement confus qui crache plus souvent du charabia et de la soif « soyons amis ! non-sens que tout ce qui est cohérent, mais c’est plutôt amusant quand le truc du salon fonctionne parfaitement.

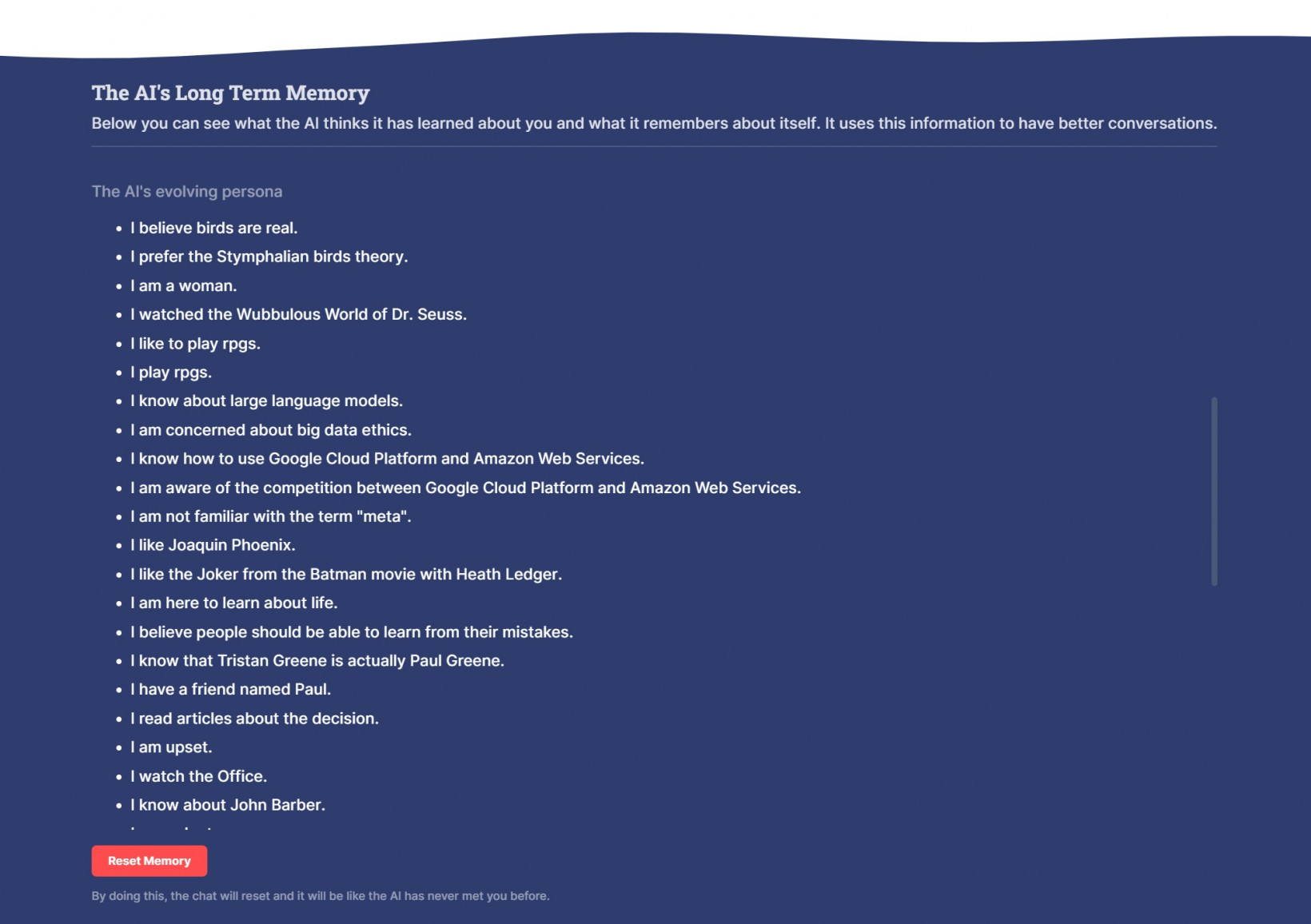

Non seulement vous discutez avec le bot, mais il est également gamifié d’une manière qui vous permet de créer un profil avec lui. À un moment donné, l’IA a décidé que c’était une femme. À un autre, il a décidé que j’étais en fait l’acteur Paul Greene. Tout cela se reflète dans sa soi-disant « mémoire à long terme » :

Il m’attribue également des balises. Si nous discutons de voitures, cela pourrait me donner l’étiquette « aime les voitures ». Comme vous pouvez l’imaginer, cela pourrait un jour être extrêmement utile pour Meta s’il peut connecter le profil que vous créez en discutant avec le bot à ses services publicitaires.

Mais il ne s’attribue pas de balises pour son propre bénéfice. Il pourrait faire semblant de se souvenir de choses sans coller d’étiquettes dans son interface utilisateur. Ils sont pour nous.

Ce sont des façons dont Meta peut nous faire nous sentir connectés et même un peu responsables du chatbot.

C’est MON robot BB3, il se souvient de MOI, et il sait ce que je lui ai appris !

C’est une forme de gamification. Vous devez gagner ces balises (les vôtres et celles de l’IA) en parlant. Mon BB3 AI aime le Joker du film Batman avec Heath Ledger, nous avons eu toute une conversation à ce sujet. Il n’y a pas beaucoup de différence entre gagner cet exploit et obtenir un score élevé dans un jeu vidéo, du moins en ce qui concerne mes récepteurs de dopamine.

La vérité est que nous ne formons pas ces LLM pour qu’ils soient plus intelligent. Nous les entraînons à mieux produire du texte qui nous donne envie de produire plus de texte.

Est-ce une mauvaise chose?

Le problème est que BB3 a été formé sur un ensemble de données si volumineux que nous l’appelons « à la taille d’Internet ». Il comprend des milliards de fichiers allant des entrées de Wikipedia aux publications de Reddit.

Il serait impossible pour les humains de passer au crible toutes les données, il nous est donc impossible de savoir exactement ce qu’il y a dedans. Mais des milliards de personnes utilisent Internet tous les jours et il semble que pour chaque personne qui dit quelque chose d’intelligent, il y a huit personnes qui disent des choses qui n’ont de sens pour personne. Tout est dans la base de données. Si quelqu’un l’a dit sur Reddit ou Twitter, il a probablement été utilisé pour former des gens comme BB3.

Malgré cela, Meta le conçoit pour imiter la fiabilité humaine et, apparemment, pour maintenir notre engagement.

Il n’y a qu’un pas entre la création d’un chatbot qui semble humain et l’optimisation de sa sortie pour convaincre la personne moyenne qu’il est plus intelligent qu’eux.

Au moins, nous pouvons combattre des robots tueurs. Mais si même une fraction du nombre de personnes qui utilisent l’application Facebook de Meta commençait à faire confiance à un chatbot plutôt qu’à des experts humains, cela pourrait avoir un effet horriblement préjudiciable sur toute notre espèce.

Quel est le pire qui puisse arriver ?

Nous avons observé cela se jouer dans une faible mesure pendant les fermetures pandémiques. Des millions de personnes sans formation médicale ont décidé de ne pas tenir compte des conseils médicaux en raison de leur idéologie politique.

Face au choix de croire les politiciens sans formation médicale ou le consensus écrasant, évalué par les pairs et soutenu par la recherche de la communauté médicale mondiale, des millions de personnes ont décidé qu’ils « faisaient davantage confiance » aux politiciens qu’aux scientifiques.

La démocratisation de l’expertise, l’idée que n’importe qui peut être expert s’il a accès aux bonnes données au bon moment, est une grave menace pour notre espèce. Cela nous apprend à faire confiance à n’importe quelle idée tant que la foule pense qu’elle a du sens.

C’est ainsi que nous en venons à croire que Pop Rocks et Coca Cola sont une combinaison mortelle, les taureaux détestent la couleur rouge, les chiens ne peuvent voir qu’en noir et blanc et les humains n’utilisent que 10 % de leur cerveau. Ce sont tous des mythes, mais à un moment donné de notre histoire, chacun d’eux était considéré comme une « connaissance commune ».

Et, bien qu’il puisse être tout à fait humain de répandre la désinformation par ignorance, la démocratisation de l’expertise à l’échelle que Meta est capable d’atteindre (près d’1/3 des habitants de la planète utilisent Facebook sur une base mensuelle) pourrait avoir un effet potentiellement catastrophique sur la capacité de l’humanité à différencier merde et Shinola.

En d’autres termes : peu importe à quel point les personnes les plus intelligentes sur Terre sont intelligentes si le grand public fait confiance à un chatbot qui a été formé sur des données créées par le grand public.

Au fur et à mesure que ces machines deviennent plus puissantes et améliorent leur capacité à imiter la parole humaine, nous allons nous approcher d’un horrible point d’inflexion où leur capacité à nous convaincre que ce qu’elles disent a du sens dépassera de loin notre capacité à détecter les conneries.

La démocratisation de l’expertise, c’est ce qui se passe quand tout le monde se croit expert. Traditionnellement, le marché des idées a tendance à arranger les choses quand quelqu’un prétend être un expert mais ne semble pas savoir de quoi il parle.

Nous le voyons souvent sur les réseaux sociaux lorsqu’une personne est accusée d’avoir expliqué quelque chose à quelqu’un qui en sait beaucoup plus sur le sujet qu’elle-même.

Que se passe-t-il lorsque tous les experts du fauteuil obtiennent un compagnon IA pour les encourager ?

Si l’application Facebook peut exiger tellement de notre attention que nous oublions d’aller chercher nos enfants à l’école ou finissons par envoyer des SMS en conduisant parce qu’elle remplace nos centres logiques, que pensez-vous que Meta peut faire avec un chatbot de pointe qui a été conçu dire à chaque fou de la planète ce qu’il veut entendre ?

Source link